- 6.96 MB

- 2021-05-14 发布

- 1、本文档由用户上传,淘文库整理发布,可阅读全部内容。

- 2、本文档内容版权归属内容提供方,所产生的收益全部归内容提供方所有。如果您对本文有版权争议,请立即联系网站客服。

- 3、本文档由用户上传,本站不保证质量和数量令人满意,可能有诸多瑕疵,付费之前,请仔细阅读内容确认后进行付费下载。

- 网站客服QQ:403074932

目录

骨干网络架构与路由策略

Web cache

、

DNS

、流控系统介绍

省网组织结构与路由交换方式

高价值业务的区分、标识原则及保障方法

骨干网络架构与路由策略

网络概述

网络现状

路由组织策略

网络演进

骨干网络架构与路由策略

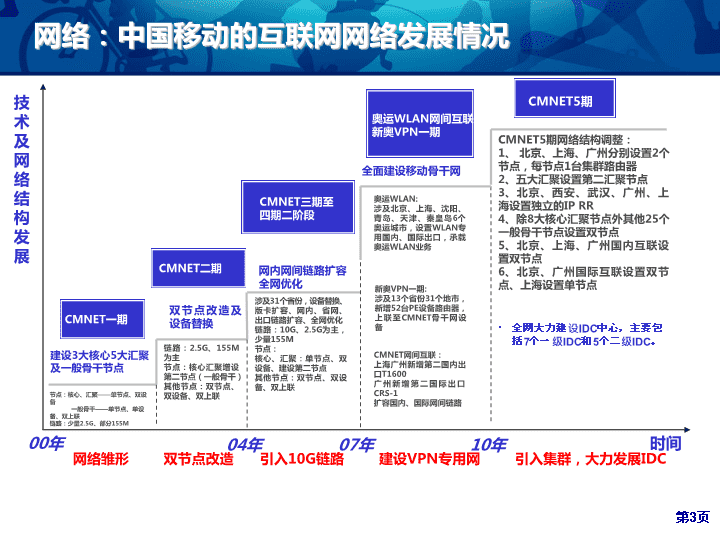

网络:中国移动的互联网网络发展情况

04

年

链路:

2.5G

、

155M

为主

节点:核心汇聚增设第二节点(一般骨干)

其他节点:双节点、双设备、双上联

节点:核心、汇聚

——

单节点、双设备

一般骨干

——

单节点、单设备、双上联

链路:少量

2.5G

、部分

155M

建设

3

大核心

5

大汇聚及一般骨干节点

双节点改造及设备替换

网内网间链路扩容

全网优化

涉及

31

个省份,设备替换、版卡扩容、网内、省网、出口链路扩容、全网优化

链路:

10G

、

2.5G

为主,少量

155M

节点:

核心、汇聚:单节点、双设备、建设第二节点

其他节点:双节点、双设备、双上联

技术及网络

结构

发展

时间

CMNET

一期

CMNET

二期

CMNET

三期

至四

期二阶段

CMNET5

期

全面建设移动骨干网

10

年

00

年

07

年

奥运

WLAN

网

间互联

新奥

VPN

一期

CMNET5

期网络结构调整:

1

、 北京、上海、广州分别设置

2

个节点,每节点

1

台集群路由器

2

、五大汇聚设置第二汇聚节点

3

、北京、西安、武汉、广州、上海设置独立的

IP RR

4

、除

8

大核心汇聚节点外其他

25

个一般骨干节点设置双节点

5

、北京、上海、广州国内互联设置双节点

6

、北京、广州国际互联设置双节点、上海设置单节点

奥运

WLAN:

涉及北京、上海、沈阳、青岛、天津、秦皇岛

6

个奥运城市,设置

WLAN

专用国内、国际出口,承载奥运

WLAN

业务

新奥

VPN

一期

:

涉及

13

个省份

31

个地市,新增

52

台

PE

设备路由器,上联至

CMNET

骨干网设备

CMNET

网间互联:

上海广州新增第二国内出口

T1600

广州新增第二国际出口

CRS-1

扩容国内、国际网间链路

全网大力建设

IDC

中心,主要包括

7

个一级

IDC

和

5

个二级

IDC

。

网络雏形

双节点改造

引入

10G

链路

建设

VPN

专用网

引入集群,大力发展

IDC

内容:中国移动的互联网内容发展情况

07

年

音乐随身听

全曲下载

飞信

音乐搜索

短信转移

/

过滤

/

仓库

基本语音,短信

前传等补充业务

以品牌为基础解决基本通信需求

增值业务提升用户体验

数据业务大爆炸

手机动漫

可视电话

MM

SP

截至

2009

年

9

月共有合作

SP7258

家

,

其中全网

SP

共

879

家,开展合作业务

8.3

万个

移动智能网

业务

种类

时间

基本业务:

9

种

补充业务:

7

种

话音增值业务:

18

余种

数据增值业务:

70

余种

条码识别

条码凭证

全业务运营

公共安全

绿色农业

工业监控

智能交通

环境监测

电子广告

远程医疗

智能家居

多媒体化

、定制化

11

年

02

年

基地业务,互联网业务

互联网

化

用户:中国移动的互联网用户发展情况

WAP

CSD

GPRS

WAP

CSD

GPRS

WLAN

专线

CSD

GPRS

WLAN

专线

家庭宽带

集团客户

TD

VIP

客户

2000

2012

2003

WAP

手机用户发展

:手机用户数从不足

2000

万增长到

4 .5

亿。

宽带用户发展:

宽带用户数从

100

万左右发展到目前的近

1000

万,网络承载的流量增加超过

12

倍。

WLAN

大发展

:

WLAN

网络经历了巨大发展,

AP

数量

20

万到

200

万。

Wlan

用户从不足

10

万增长到

3000

万。

用户种类

骨干网络架构与路由策略

网络演进

网络现状

路由组织策略

网络演进

骨干网络架构与路由策略

CMNET

网络概况

骨干核心层

(

北京、上海、广州)

:

负责中转省际流量、网间流量;

骨干汇聚层

(

西安、成都、武汉、南京、沈阳

5

省)

:

负责中转省际流量;

骨干接入层

(

23

个省)

:

负责汇聚本省流量。

省网核心层

CMNET

网总体分为两层结构,分为

骨干网、省网

。

骨干

网按功能层次分为

骨干核心层、骨干汇聚层、骨干接入层

。

省网分为两种结构。其中

29

省采用一个自治域,分为

省网核心、省网接入、城域网接入

三层。

北京

广州

上海

成都

武汉

南京

沈阳

西安

骨干网

省网

省网

城域网

A

结构(

29

省)

B

结构(广东、江西)

AS9808

同一

AS

不同

AS

全网组网原则:无论骨干和省网、城域网,

一般接入节点至少连接两个上级节点(汇聚和核心)。城域网核心至少连接两个省网核心,省网核心至少连接两个以上骨干核心(或汇聚)。

城域网

接入

层

省网接入层

/

城域网核心

CMNET

骨干网的结构

总体分层

CMNET

骨干网网络层次目前分为核心骨干层、汇接骨干层、一般骨干层三层结构

。另外与核心层还连接有国际出入口层、互联互通层。一般接入层及以上即为省际骨干部分。(流量小情况下,分层汇聚能够节省端口。)

骨干网按照地域分为

3

大片区,

3

大片区又细分为

8

个大区:

北京片区:北京大区、沈阳大区、西安大区

上海片区:上海大区、南京大区、武汉大区

广州片区:广州大区、成都大区

当前各片区向外发布路由

优选

情况如下(条数):

电信互联,北京:上海:广州

=300:287:359

联通互联,北京:上海:广州

=374:223:393

8

CMNET

骨干网国内拓扑结构

核心层

北京、上海、广州

3

个节点及其相连链路构成骨干核心层。其中,北京、上海、广州为核心节点,核心层北上广提供大区内省份流量的交换,并负责全网与国际

Internet

、国内其他运营商的互联。

CMNET

六期之后,部分省增加了到核心的连接。比如,青岛上海;福州上海。

汇聚层

汇接层负责汇接各省到骨干网的连接。南京、武汉、成都、西安、沈阳节点为汇聚节点(相当于中国电信的普通核心),负责本大区内省份流量之间的交换

原则上同省的两个接入节点同时连至三个核心节点中的一个、按区域连至五个汇聚节点的一个或多个。只有杭州连接至三个核心,并连接到南京。

CMNET

六期后将增加到核心以及汇聚的多个方向连接,比如济南武汉、厦门武汉等。

接入层

接入层按照一个省份两个骨干接入节点设置,只负责汇聚本省省际流量和出网流量。

9

CMNET

骨干网络节点-概述

网络节点:

2011

年底后,覆盖全国

31

个省(区市)

36

节点城市

划分片区负责网间入流量调整:即按照片区广播网间路由,吸引入流量;

划分大区负责网内流量调整,中国移动大区内流量优先通过汇聚节点转发

。

10

CMNET

骨干国际网络结构

国际出口层

北京、上海、广州的路由器组成,是国际网络的核心部分,面向国内连接骨干核心层,面向国外连接海外

POP

点,用来汇聚

CMNET

出入国内的国际流量,建立出国流量的缓冲区,设立这个层面的一个重要目的是方便国际出口配套工程实施。目前北京出口配套工程原因暂停使用。

国际接入层

国际接入层主要是指海外

POP

,主要用来接入海外网络,及与其他海外

ISP

间的互联链路(包括部分

PEER

电路和购买的

TRANSIT

电路)。它的主要作用是降低

PEER

互联成本和购买

Transit

的成本。每个节点规划两台路由器。

美国

POP

点:洛杉矶、旧金山的国际互联网接入。

香港

POP

点:负责香港本地和部分东南亚、欧洲的互联网接入。

伦敦

POP

点:英国伦敦,负责欧洲国际互联网接入。(目前

1

台,未启用)

11

CMNET骨干网

网络现状-网间互联节点设置

国内互联节点:

北京、上海、广州,均为双节点设置。

国际互联路由器:

北

京、上海、广州,均为双节点设置,由于安全配套尚未到位,故北京国际出口、上海国际出口

2

、广州国际出口

1

暂未上线。

NAP

互联路由器

:

北京、上海、广州;均为单节点设置。

海外

POP

点

由中国移动国际公司运营的

CMNET

国际网(

CMI

)提供,拥有独立的

自制系

统,为

CMNET

提供国际互联业务。现有北美

POP

点(单局址双设备)、香港

POP

点(单局址双设备)及欧洲

POP

点(尚未承载业务)

网间互联

电信、联通等国内运营商

北京

1

上海

1

广州

1

北京

2

北美

香港

Sprint

、

AT&T

、

DT

等国际运营商

核心

节点

CMI

CMNET

六期工程建成后的结构

骨干节点网络结构调整

原核心骨干层和汇聚骨干层调整为

骨干核心层

,汇聚和疏通出网的业务量,实现跨省业务的有效疏通;北京、上海、广州、武汉、南京、四川、西安、沈阳;除西安、沈阳外,骨干核心节点之间全网状互联。

原一般骨干层调整为

骨干接入层

,用于汇接本省的出省的业务量,全网目前

23

个骨干接入节点,六期工程内容:

新增

1

个天津私有云节点作为骨干接入节点;

增加部分接入节点接入方向;

苏州城域网流量直连骨干网南京、上海节点,进行扁平化试点疏通方式;

国内出口节点结构调整方案

目前全网流量过于集中于北京、上海、广州三个核心,故障时影响面大且难以疏通,北京、上海、广州三个核心节点设备及机房的压力大。

本次工程新增武汉、南京、成都

3

个节点作为国内互联节点,分散北京、上海、广州三个核心节点的压力,降低故障时的影响面。

六期原设计于

2012

年

8

月完工,满足网络需求到

2012

年底,扩容后总带宽为

5.9T

;

13

155M

155M/2.5G

2.5G

2.5G/10G

接

口

技术

10G

CMNET

骨干业务量和端口技术发展情况

业务量增长:

2003

年到

11

年,网络承载流量增长

175

倍,年均增长

90.7%

08

年到

11

年:

业务量增长

8

倍,年均增长

100%

,其中

IDC

流量贡献从

5G

发展到

240G

;用户数方面,宽带从

100

万户发展到

1000

万户;

WLAN

从不到

20

万发展到超过

800

万。

建设容量:

2003

年到

11

年,网络建设容量增长约

45

倍,年均增长

62.7%

骨干网总链路带宽:移动

1.8T

,电信

21T

,联通

16T

(互联网发展报告数据)

技术发展方面:从

08

年到

11

年,主流端口技术一直停留在

10G/Port

CMNET

承载

流量增长情况

G

网络容量建设速度远低于业务量增长

,且

10G

端口技术未升级,导致原有网络结构日趋不适应新的流量模型

。

CMNET

网络

量总容量建设情况

G

14

年均增长超过

90%

年均增长超过

100%

在业务高速增长情况下,

CMNET

工程期末拥塞状态

--

五期工程原计划于

2011

年

11

月份完工,推迟到今年

9

月份(预计),目前仍有

270

条骨干链路未到位(五期建设规划共

911

条)

---

六期原设计于

2012

年

8

月完工,目前未完成设备集采,预计工程将延后;

---2012

年

3

月全

网省际链路

共

205

条

,

均值

流量超过

40%

且峰值流量超过

80%

的链路共有

37

条

(占

18%

)

,峰值利用率达到

100%

的

共

31

条

链路(占

15%

)

。

带宽:

Gbps

15

骨干承载总流量情况

骨干网承载总流量之和为

824Gbps

。

骨干网承载省际总流量为

555Gbps

,占全部流量的

67%

。

骨干网承载网间

总

流量为

269Gbps

,占全部流量的

33%

。

各省业务量发展不平衡。

骨干网承载总流量

=

骨干网承载的省际流量

+

骨干网承载的网间流量

16

骨干网承载的省际流量情况

骨干网承载的省际流量之和为

555Gbps

。

其中,排名前

10

省份的省际互访总流量之和为

421Gbps

,占出省际流量的

76%

。

Gbps

17

骨干网

承载的网

间流量情况

各省从骨干网疏通网间流量情况

Gbps

各省通过骨干网疏通网间流量之和为

269Gbps

。其中,排名前

10

的省份流量之和为

175Gbps

,占出全部流量的

65%

。

18

骨干网承载的网间流量情况

各省从

骨干网到

电信

方向

流量情况

Gbps

各省从骨干网到

中国电信

流量为

91.9Gbps

,排名前十省份流量总和为

59.5Gbps

,占

64.8%

。

各省从

骨干网到

联通

方向

流量情况

Gbps

各省从骨干网到中国联通流量为

75Gbps

,排名前十省份流量总和为

48.7Gbps

,占

65%

。

19

附录:省网第三方出口流量情况

第三方出口疏通流量峰值为

176Gbps

,平均流量为

88Gbps

,占全网出网流量的

24%

。

20

骨干网承载的省际流量

top10

省份的流量流向

Gbps

Gbps

Gbps

Gbps

浙江省际流量为

93.5Gbps

江苏省际流量

为

78.3Gbps

上海省际流量

为

61.8Gbps

山东省际流量

为

40Gbps

21

骨干网

承载的省

际流量

top10

省份的流量

流向

Gbps

Gbps

Gbps

Gbps

江西

省

际流量

为

34.2Gbps

广东

省际

流量

为

25.6Gbps

河南

省际

流量

为

24.8Gbps

山西

省际

流量

为

29Gbps

22

骨干网

承载的省

际流量

top10

省份的流量

流向

Gbps

Gbps

福建省际流量

为

18.5Gbps

四川省际流量

为

15.1Gbps

全国

31

省通过骨干网承载的省际流量详细情况参见:

23

CMNET

骨干网络-流量中转的路由

CMNET

网络流量疏通遵照最短路径优先原则。

(

中国电信是按照角色转发,区分片区和大区,主要原因中国电信为多平面组网,路由更复杂。)

中国移动优先考虑距离,

metric

设置和距离成正比,在距离相等的情况下,才考虑角色,按照跳数最小原则设计。

中国移动路由举例

每增加一跳

Metric

增加

300

:

北京

到

海口

:北

京

-

广州

-

海

口,而

不

是北

京

-

武汉

-

广州

-

海

口,增加一

跳增加

metric

为

300

。

距离不同跳数相同走最短路径

:长春到哈尔滨:长春

-

沈阳

-

哈尔滨(

metric=11139

);长春

-

北京

-

哈尔滨(

metric=13661

),

24

CMNET骨干网

网络现状-设备配置情况

CMNET

骨干网设备配置情况

骨干网全网共设

置

182

台

路由器、

26

台三层交换机

设备配置

JUNIPER

CISCO

华为

TXP

集群

T1600

M320

CRS1-16

GSR 12008

三层

交换机

NE5000E

NE40E

核心骨干

6

汇接骨干

10

一般骨干

12

50

26

国内互联

6

国际互联

4

1

2

2

NAP

互联

3

IP /VPN RR

10

(

IP

)

4

(

VPN

)

VPN PE

72

合计

6

42

51

2

3

26

2

76

208

CMNET骨干网

网络现状

—

国内网间互联电路

互联链路

对方运营商

CMNET

现状

设计到达端口能力

(

五期后

)

实际开通(

2012

年

4

月)

北京

电信

8

×

10G

3×

10G

联通

8

×

10G

2

×

10G

中国教育网

1

×

2.5G

1

×

2.5G

中国铁通

2

×

10G

2×

2.5G+1×10G

世纪互联

1

×

2.5G

1

×

2.5G

合计

185G

70G

上海

电信

8

×

10G

3x10G

联通

8

×

10G

3

×

10G

中国教育网

1

×

10G

1

×

10G

中国铁通

2

×

10G

3x10G

合计

182.5G

70G

广州

电信

8

×

10G

3x10G

联通

8

×

10G+1G

2x0G

中国铁通

2

×

10G

2x10G

中国教育网

1

×

GE

合计

181G

70G

总计

548.5G

210G

CMNET骨干网

网络现状

—

国际网间互联电路

国际出口节点

CMNET

骨干网国际互联

至内侧核心路由器(五期后)

至外侧互联

已具备端口

开通情况

上海

5x10G/

台,

共两台

至国际运营商直联

1×155M

1×155M

至北美

POP

点

2x10G/

台

2x10G

至香港

POP

点

3x10G/

台

2x10G

(尚未开通)

至欧洲

POP

点

1x10G/

台

1x10G

(尚未开通)

广州

7x10G/

台,

共两台

至北美

POP

点

2x10G/

台

2x10G

(尚未开通)

至香港

POP

点

5x10G/

台

5X10G

合计

130G+155M

120G+155M

骨干网络架构与路由策略

网络演进

网络现状

路由组

织

网络演进

骨干网络架构与路由策略

总体网络规划:

IGP

协议

全网

IGP

采用

ISIS

全网所有核心、

汇

聚、一般骨干、出口路由器、业务交换机全网属于

ISIS Level2

ISIS

邻居间运行

MD5

认证

总体网络规划:

IGP

协议 流量路径规划

CMnet

骨干网节点间流量疏通基本原则是逐级向上疏通。在满足

该

原则的同时,优选传输距离较短的路径:

核心节点间流量

任何情况下都通核心节点间链路疏通

汇接节点间流量

优选通过汇聚节点间链路疏通

次选通过核心节点间链路疏通

接入节点间流量

优选通过接入节点间链路疏通

次选通过汇聚节点间链路疏通

再选通过核心节点间链路疏通

总体网络规划:

IGP

协议

Metric

规划

IGP Metric

规划方式一般包括两种:

链路

参考

带宽+链路角色

即选择带宽最大的路径疏通流量,该方式比较适合对带宽敏感的业务,如互联网业务。

传输距离+链路角色

即选择传输距离最短路径疏通流量,该方式比较适合时延敏感的业务,如语音业务。

CMnet

骨干网采用模式

2

“传输距离+链路角色”规划

IGP Metric

。即两点间流量优选传输距离最短的路径。

总体网络规划:

IGP

协议

Metric

规划

Metric

规划

Metric=

链路角色

+

传输距离

类型

参考值

核心、汇聚路由器

CR

间链路

300

+传输距离

1.

出口路由器至核心路由器

CR

间链路

2.

一般骨干至核心汇聚

CR

间链路

3.

业务交换机至核心汇聚

CR

间链路

4.VPN PE

至核心汇聚

CR

间链路

5000

+传输距离

域名管控至国际出口

国际出口至

POP

点

300

+传输距离

同省一般骨干路由器

BR

间

300

+传输距离

同大区核心汇聚

CR

间链路

300+[1,n]

RR

到核心汇聚

CR

间链路

20000

同城

RR

间链路

20000

VPN PE

路由器至一般骨干路由器间链路

300

+传输距离

同城

VPN PE

路由器间链路

200+[1,n]

总体网络规划:

BGP

规划

省网与骨干网间运行

EBGP

协议

骨干

网在北京、上海、广州、武汉、西安设置

5

对

10

台

IP

路由反射器

10

台

RR

是

full mesh

的

BGP

关系,骨干网节点根据归属关系作为

RR

的客户端

国

际出口、国内出口及

NAP

点路由器是北上广的

RR

的

Client

POP

点、国内互联运营商及

NAP

点互联与骨干网出口建立

EBGP

关系

总体

网络

规划:

VRR

设置

VRR

设置

:

北京、广州

分别设置两台

VRR

、全网共设置

4

台

VRR

;

4

台

VRR

之间构成

Full Mesh MP-iBGP

连接;

北京、广东所辖地市的

PE

路由器和本省所在核心节点两台

VRR

建立

BGP

关系;

其它省的所辖地址的

PE

路由器,根

据

规划与相应

的

VRR

建立

BGP

关系。

总体网络规划:

LDP

规划

LDP

协议规划

全网所有骨干、核心、一般骨干间运行

LDP

协议

仅针对

PE

的

loopback

地址分配标签

LDP

邻居间运行

MD5

认证

端口启用

IGP

、

LDP

同步

总体网络规划:策略规划

至其他运营商:

CMNET

骨干网通告给出口路由器的路由包括

CMNET

省网路由及

CMNET

汇聚路由;

出口路由器向对端运营商及

POP

点通告路由时需要过滤掉私有

AS

号;

总体网络规划:策略规划

至省网:

骨干

网向省网发送

CMNET

网内路由,缺省路由;

根

据情况发送国内路由及国际

Internet

路由;

接受省网汇聚及细化路由,

掩码长度不大于

24

位

;

骨干

网对接收的省网路由设置相应的

Community

总体网络规划:策略规划

国内出

口策略:

通过

MED

值控制其他运营商进入

CMNET

的流量

;

本大区的流量优先从本大区的国内出口流回

CMNET

;

例

如北京大区的国内出口通告路由时将携带北京大区

Community

的路由的

MED

宣告为

100

,上海、广州大区的路由

MED

宣告为

300

,则访问北京大区的流量优先从北京国内出口流回

CMNET

;

由于其他运营商发给

CMNET

的路由在各个出口是有差异的,故

出网流量由对端运营商控制

。

排

除故障或调整流量时可以通过通告较低的

MED

控制某个省的流量从指定的出口流入

CMNET

。

总体网络规划:策略规划

国际出口策略:

通过附加

MED

的方式控制国际运营商进入

CMNET

的流量

;

本大区的流量优先从本大区的国际出口流回

CMNET

;

与国内互联策略类似,

北京大区的国内出口通告路由时将携带北京大区

Community

的路由的

MED

宣告为

100

,上海、广州大区的路由

MED

宣告为

300

,则访问北京大区的流量优先从北京国内出口流回

CMNET

;

由于

CMNET

国际网是由国际公司运营的有独立自制系统号的网络,故通过协商,国际公司在

POP

点接收对端运营商路由时根据

AS Path

等属性,对接收的路由标记相应的本地优先级。

由

于

CMNET

和

CMI

间运行的是

EBGP

协议,

本地优先

级属性不会传递给

EBGP

邻居,

故

POP

点在向

CMNET

发送路由时应根据路由的本地优先级值打上相应的

Community

,

CMNET

国际出口接收路由后,根据

Community

还原本地优先级,以便出网国际业务可以选择最优路径。

骨干网络架构与路由策略

网络演进

网络现状

路由组织

网络演进

骨干网络架构与路由策略

我省

CMNET

省网与城域网、

IDC

、第三方、省网核心交换机路由协议采用

OSPF

,

cost

值均为

1000

。

我省

CMNET

城域网节点通过

OSPF

发布业务路由,并接收省网核心节点通过

OSPF

下发的缺省路由。

CMNET

网络演进总原则:贴近内容分布规划

聚焦于互联网内容,规划中国移动的

CMNET

网络架构

以内容为核心

(

IDC/

出口互联

/CDN

),驱动

IP

网络架构的扁平化调整

先期以带宽弥补内容缺乏短板,逐步积累内容传送技术,最终形成

光

+IP+CDN

协同的内容传输平台,支撑超宽带业务发展

在网络确定的前提下

,

高密度内容,尤其是视频内容努力下沉到省网甚至城域网

,提升视频感知的同时,节省网络传输投资。低密度内容确保全网共享。

核心

核心

西安

北京

杭州

广东

武汉

天津

成都

重庆

安徽

福建

广西

湖南

江西

云南

南京

。。。

省网

1

省网

2

出网内容为主,内容集中在北上广

出口和互联路由器上

核心

核心

西安

北京

杭州

广东

武汉

天津

成都

重庆

安徽

福建

广西

湖南

江西

云南

南京

。。。

城域网

1

省网

2

以内容为核心扁平化

;

省网分裂为大

城域网

;

大内容城域网上联核心平面

城域网

2

核心

核心

西安

北京

杭州

广东

武汉

天津

成都

重庆

安徽

福建

广西

湖南

江西

云南

南京

。。。

城域网

1

省网

2

为高清视频和大带宽应用建设

CDN

城域网

2

互联出口

大型

IDC

CP

互联

互联出口

大型

IDC

CP

互联

扁平化

简单化

拓扑稳定

易于扩展

高转发效率

高清视频

内容本地化

44

网络结构问题

1

:骨干汇聚节点未设置国内出口,造成核心流量过集中

----

迂回和绕转造成端口和带宽浪费

随着业务的增长,由于汇聚节点未设置互联出口,流量过于集中于现有三个骨干核心节点,汇聚节点未充分发挥效率。

问题后果:导致核心节点的升级调整和故障影响大。

功能

大区

承载流量

占比

核心节点

北京

175

23%

上海

221

30%

广州

160

21%

汇聚节点

成都

20

3%

沈阳

11

1%

南京

65

9%

武汉

41

5%

西安

14

2%

武汉

41

5%

合计

748

100%

核心、汇聚节点承担的流量

网内

74.3%

骨干网流量需要通过核心节点承载,核心和汇聚节点之间

流量疏通不均衡

。

根本原因是因为

互联互通的节点只设置在北上广

,且

CMNET

对外网互访依赖较为严重。(中国电信:

10%

以内,中国移动

50%

)

数据来源:数据网管

北京

1

西安

1

太原

1

32G

/40G

太原

2

4.2G/

40G

电信

14.5G

其他省

西北大区省份

40G

10G

CMNET

骨干网

7.5G

4G

3G

现状

北京

1

西安

1

太原

1

18G

/40G

太原

2

18G

/40G

电信

联通

7G

其他省

西北大区省份

5G

CMNET

4.5G

2G

3G

电信

联通

铁通

西安升级为核心后

7G

5G

2G

20G

铁通

联通

铁通

网络结构现状:西安无国内出口,

山西省

36.2G

的流量

90%

通过北京疏通。为保障安全,西安

1

到北京

1

之间需预留

40G

备份带宽资源。

目标方案:西安增加国内出口

20G

后,西安

1

到北京

1

之间只需预留

20G

备份带宽。

解决方案:将西安等

5

个汇聚节点和浙江节点逐步按需增加网间出口

方案效果:

如果在西安增加疏通

20G

国内出口,就可节省北京到西安之间的传输链路

2

条

10G

,

4

个

10G

端口,同时也能提升北京到太原之间的质量。

网间互联出口并非越多越好,要有适当的度,每增加一个互联出口:

1

、跨运营商业务的路径增加,排障时间成倍增加

。

2

、多出口流量调控的难度增加,利用率和平衡效果变差

。同一个出口的链路负荷分担的效果非常好,不同出口之间负荷分担需依靠维护员手工不断尝试调整,由于

40

万条路由的复杂性,过多核心将导致同样的质量保障情况下,互联出口平均利用效率下降。

3

、

IP

技术采用统计复用原理,适当汇聚后的抗突发能力、冗余备份能力更强。

网络结构问题

1

:骨干汇聚节点未设置国内出口,造成核心流量过集中

----

迂回和绕转造成端口和带宽浪费

核心节点逐步增至

9

个

网络结构问题

1

解决方案:适当增加核心节点数量

将汇聚节点增加网间出口,升级为核心节点,同样也推动了骨干核心和汇聚节点扁平化,使得

CMNET

骨干从三层变为两层,减少了网内访问跳数

3

个核心

5

个汇聚节点

23

个接入节点

北京、上海、广州

武汉、沈阳、

西安、南京、成都

核心节点具备疏通

网间流量的能力

汇聚节点会转发

接入节点的流量

仅疏通本省流量

现状

核心扁平化

演进前:核心、汇聚、接入节点

9

个核心节点

23

个接入节点

北京、上海、广州、武汉、沈阳、西安、南京、成都、杭州

核心节点具备疏通

网间流量的能力

仅疏通本省流量

演进后:核心、接入节点

方案效果:

每个核心节点承担的流量将降低到

10%

以内

,有效减少网络升级和故障发生时的业务影响。

备注:定义核心节点的两个要素

1

、有汇聚转发周边省份流量的需求。

(

核心节点自身处于传输网汇聚点,且周边省份流量相对较小,有经过自身中转提升效率的需求)。

2

、由负责疏通网间流量的需求。

47

目标

网络结构问题问题

2

:部分大流量省际节点之间未设直达

---

当前结构造成大流量经过核心中转,效率低

调整直连的本质

:随着网内流量增大,接口技术未升级,使得部分大流量省之间经过核心转发不

再

合理,需要根据流量增长和端口技术不断优化直连链路。

解决方案:增加大流量省份之间的跨省直连链路。本质是骨干网层面扁平化,“该直连,就直连”。

网络结构现状:南昌

-

南京流量需中转,

在

2012

年中转流量超过

16G

后,上海需要为南昌多设置

4

个

10G

端口

。

目标方案:增加南京

-

南昌直连链路,

能够节省

4

个

10G

端口,在保障冗余能力的情况下,提高了中转效率。

南京

-

南昌流量疏通情况

上海

1

武汉

1

南昌

1

南昌

2

CMNET

16G/

20G

20G

南京

1

上海

1

武汉

1

南昌

1

南昌

2

CMNET

南京

1

16G/

30G

16G/

20G

30G

30G

30G

方案效果:增加跨省

直连后,能够节省端口,提高中转效率。

大流量时设置直连:

省端口、增加了骨干路由,减少了冗余程度。

小流量时设置直连:

费端口、增路由。

大流量和小流量的标准

随技术在不断变化,结构也要随之变化,通常设计一个超过

3

年的网络结构是没有意义的。

增加直连要保证一定程度的冗余:

要保证直连中断时,所归属的核心节点能够作一定的备份。

适度增加直连的原因:

网络结构问题

3

:出省流量大的城域网未直连骨干网

----

造成经过省网核心中转效率低

解决方案:增加出省流量大的城域网双跨省网和骨干的力度。本质是大流量的城域网扁平化,“该双跨,就双跨”。

方案效果:出省流量大的城域网双跨

,能够节省端口,提高中转效率。

网络结构现状:太原城域网出省流量超过

20G

后,

山西省网核心需要为之多设置

8

个

10G

端口。

目标方案:城域网双跨,

能够节省

8

个

10G

端口,在保障冗余能力的情况下,提高了中转效率。

CMNET

骨干网

太原城域网

其他城域网

B

山西省网核心

CMNET

省网

15G/

20G

15G/

20G

CMNET

骨干网

太原城域网

其他城域网

B

山西省网核心

CMNET

省网

15G/

20G

15G/

20G

解决方案:增加出省流量大的

IDC

双跨省网和骨干的力度。本质是大流量的

IDC

扁平化,“该双跨,就双跨”。

方案效果:出省流量大的

IDC

双跨

,能够节省端口,提高中转效率。

网络结构现状:北京

IDC

出省流量超过

20G

后,北京省

网核心需要为之多设置

8

个

10G

端口。

目标方案:城域网双跨,

能够节省

8

个

10G

端口,在保障冗余能力的情况下,提高了中转效率。

CMNET

骨干网

北京

IDC

其他接入节点

北京省网核心

CMNET

省网

15G/

20G

15G/

20G

CMNET

骨干网

北京

IDC

其他接入节点

北京省网核心

CMNET

省网

15G/

20G

15G/

20G

网络结构问题

4

:出省流量大

IDC

未直连骨干网

----

造成经过省网核心中转效率低

天津省网

南京

C1

天津

A1

北京

C1

北京

C2

南京

C2

天津

A2

武汉

C1

上海

C1

上海

C2

北京

E1

三角型

口字型

2to2

:

A

、

Z

节点分别设置

2

台设备

三角形:

A

端

1

台设备连接

Z

端

2

台设备

口字型:

A

端

2

台设备连接

Z

端

2

台设备

江西省网

南昌

A1

南昌

A2

三角型

口字型

CMnet

省网

其它运营商

国内、国际运营商

国内、国际运营商

南京

E1

武汉

E1

上海

E1

天津P

1

天津P

2

南昌P

1

南昌P

2

骨干网组网结构分析

-

三角形

OR

口字型

武汉

C2

-

52

-

网络结构演进:

三角形

vs

口字型

对

比分析

对比项目

三角型

口字型

1

网内流量疏通

基于

IGP

选路,较均衡

基于

IGP

选路,较均衡

1

网间流量疏通

初期和后期,调控简单

初期,调控较复杂;后期调控简单

3

链路数

相同

相同

4

端口占用

相同

相同

5

连接维度

相同

相同

6

网络可靠性

相当

相当

网络发展初期,出口设置在北上广,较为集中,三角型较口字型疏通效果略好,适用于较小规模网络。

随着网络扁平化,出口设置在更多核心节点,口字型、三角型疏通效果相当,而

口字型更利于网络演进

。

CMNET

演进原则总结

互联网组网结构是动态,伴随流量和端口技术等需要针对性优化。针

对

CMNET

演进

优

化建议如下:

增加骨干核心节点的数量:

将南京、武汉、成都、沈阳、西安

5

个汇聚节点和杭州节点升级为核心节点,推动扁平化,提高疏通效率。

增加骨干网网间出口:

在出网流量大于

30G

的汇聚节点增加网间出口,节省核心节点间的传输链路和端口资源。出口地点:南京、武汉、成都、沈阳、西安、杭州。

大流量省份骨干节点之间增设直连:

业务量大于

14G

的可设直连(阀值随技术变化,如

40G

应用后,阀值可相应提升;

14G=10

*

2

*

70%

)。省间直连仅疏通两省直达流量。同时考虑适度增加直连的原则,所在省的归属核心要能够实现业务备份(建议备份比例超过

50%

)。

大流量城域网节点增设和骨干网的直连,同时连接骨干网和省网:

大流量的城域和

IDC

节点(例如下期规划的南京、深圳),可以双连省网和骨干。

大流量

IDC

节点双跨骨干网和省网:

IDC

节点双跨

骨干

和省

网,即省外流量直接骨干

转发

,省内流量

由

省网核心

转发

。

推进三角型组网向口字型组网转变

,增强后期网络结构优化扩展性。满足业务发展需求。

目录

骨干网络架构与路由策略

Web cache

、

DNS

、流控系统介绍

省网组织结构与路由交换方式

高价值业务的区分、标识原则及保障方法

Web cache

、

DNS

、流控系统介绍

Web cache

DNS

流控系统

骨干网络架构与路由策略

Internet

IP

承载网络

WebCache

P2PCache

特点:一次外网访问,多次内网服务

核心思想:以存储换时间、以存储换

带宽

流量拥塞点

:

省网出口

互联出口

通过截获

DNS

请求实现

解决

HTTP

流量问题

通过破解

P2P

协议或与

SP

深度合作实现

解决

P2P

流量问题

什么

是

CACHE

?

小带宽

大带宽

WEBCache

P2PCache

DPI

截获

DNS

请求

P2P

协议破解

存储内容

HTTP

页面

大文件

返回内容

WEBCache

存储器

IP

地址

P2P

文件存储器地址及用户地址列表

Web cache

Cache

系统全国部署情况:

集团

Cache

节点:北京、上海、广州

省级

WebCache

节点:

15

个

省级

P2PCache

节点:

18

个

规划中的

Cache

节点

57

厂家

Web Cache

P2P Cache

华为

√

√

宽广

√

√

Bluecoat

√

思华

√

网宿

√

√

东方网信

√

Cache

系统在全国得到了较广泛的部署:

WEB Cache

已在集团和

15

个省部署,

P2P Cache

已在

18

个省部署,共涉及

6

个厂家

Web cache

58

系统组成

DPI+

调度器

:检测出

DNS

域名解析请求,向用户或

Local DNS

发起

DNS

重定向包

负载均衡设备

:将用户请求和网络流量按照相应算法分发到

WebCache

服务器组进行处理

Web Cache

服务器

:分析请求是否在本地命中,是则直接响应;否则向源服务器发送请求,下载、缓存相应内容,并返回给用户

应用场景和限制

Web Cache

系统部署在互联互通出口,通过

DPI

设备拦截出口的

DNS

请求并重定位

到

Web

Cache

服务器,由

Web Cache

服务器统一出网取内容并做本地缓存,以此减少用户的出网流量

Web Cache

技术流程

网站

本地

DNS

调度器

出口路由器

DPI

其他运营商网络

授权

DNS

1.

用户发起网站域名的

DNS

请求

2.

本地

DNS

向外网发起域名的

DNS

请求

4.

调度器抢先响应

DNS

请求,回复

Cache

系统地址

3.

网间

DPI

将

DNS

请求复制给

Web Cache

调度器

5.

用户获得域名解析结果,地址为

Cache

系统地址

6.

用户访问

Cache

4(1).

外网

DNS

响应较晚,被丢弃

Web Cache

服务器

负载均

衡设备

用于缓存静态的

Web

页面,对于实时更新的网站或动态网页均无法缓存,对

Web

用户访问体验的改善有限

7(1).

对于不命中内容,

Cache

服务器从外网取回数据

7. Cache

命中则直接向回应用户;不命中则从外网取回数据后回应客户

P2P cache

原理

59

系统组成

DPI+

调度器:

通过

DPI

检测

P2P

请求,将请求重定向、控制在指定范围内

负载均衡设备:

负载均衡、缓存记录搜索、热点内容管理调度

P2P Cache

服务器:

缓存热点内容

应用场景和限制

P2P Cache

系统部署在互联互通出口, 由

P2P Cache

服务器统一出网取内容并做本地缓存,通过

DPI

设备拦截出口的

P2P

请求并重定位到我公司的

P2P Cache

服务器,使得用户可以直接在缓存服务器上获取相应内容,以此加速用户的下载速度,并减少用户的出网流量

P2P Cache

技术流程

出口路由器

DPI

其他运营商网络

P2P

Cache

服务器

负载均

衡设备

P2P

均为私有协议,支持情况不太好

调度器

P2P

服务商的

Tracker

服务器

1.

用户发起

P2P

请求

2.

网间

DPI

将

P2P

请求复制给

P2P Cache

调度器

3.

调度器抢先响应

P2P

请求,回复网内

Peer list

(包含

P2P Cache

服务器地址)

3(1).

外网

Peer list

响应较晚,被丢弃

外网

P2P

资源

PEER1

PEER2

4.

用户向

Peer list

中的地址发起下载

4(1).

对于不命中内容,

Cache

服务器从外网下载内容后缓存

Web cache

60

WEB Cache

系统是应对出口结算和用户体验问题的有效手段,应用效果较明显

分

担出口带宽

提升用

户体

验

缓存加速前:

146.598

秒

缓存加速后:

12.768

秒

门户网站

:

网易

视频网站

:

酷

6

缓存加速前:

365.677

秒

缓存加速后:

5.450

秒

网页浏览提速

视频播放提速

提速

11

倍

流量贡献比:缓存贡献流量占该省总流量比例

提速

66

倍

Web Cache

流量均值(

Gbps

)

Web Cache

流量贡献比

广东

2

8.34%

湖北

0.0265

1.3%

浙江

1.1

1.65%

Web cache

61

P2P

Cache

系统是应对出口结算和用户体验问题的有效手段,应用效果较明显

分

担出口带宽

提升用

户体

验

BT

迅雷

HTTP/

P2SP

eMule

LAN

25

倍

14

倍

26

倍

4

倍

WLAN

44

倍

58

倍

9

倍

20

倍

TD

5

倍

5

倍

2

倍

3

倍

各类应用使用缓存后下载速度提升倍数

P2P Cache

流量均值(

Gbps

)

P2P Cache

流量贡献比

广东

1.8

7.50%

湖北

0.663

30%

浙江

20

30.03%

Web cache

存在的问题:

62

缓存系统虽然是比较有效的缓解出口结算压力和提高用户体验的一种方式,但是缓存系统也存在一些问题,主要体现在:

缓存是一种补充手段,效果约为

70%

,潜在会影响用户感受

缓存命中率约为

70%

,动态内容一般不能缓存

缓存有一定的更新期,在更新期内部分内容不能得到实时更新,潜在影响用户感受

随着

HTTP+80

端口被广泛应用,潜在存在用户不能访问的各种隐患

缓存需要精细化运营,缓存系统需要不断的“去除隐患”和“调试优化”

“

去除隐患”:如

Web Cache

若采用

HTTP

重定向方式,对于采用了

HTTP

协议的非网页类应用(

QQ

离线文件下载)无法正确处理,影响用户使用

“调试优化”:如

Web Cache

的白名单要根据热点网站进行更新,

P2P Cache

系统需要适应大量不同

P2P

应用协议变化进行调整,以获得最好的缓存效果(类似病毒库)

全国管理手段并不具备

没有手段查看全国各省的热点列表

没有手段查看各省真实的使用效果(如缓存的使用率,访问时延等)

协同问题突出

Cache

与其他系统未能很好协同(见后面分析)

CMNet

骨干网

其他运营商网络

第三方

网络

第三方链路

DPI+

调度器

DPI+

调度器

铁通

互联互通

×

IDC

引入的网站

WEB Cache

服务器

IDC

引入的

P2P

资源

P2P Cache

服务器

集团

Web Cache

服务器

Web Cache

系统

Web Cache

系统

问题二:

WEB Cache

和

IDC

内容源重复,导致

IDC

无法使用

DPI+

调度器

2

3

4

省网

B

省网

A

问题三:

P2P Cache

无法利用

IDC

引入的

P2P

内容

问题四:

两级

WEB Cache

是否冲突?

省网

C

省网

D

DPI+

调度器

多次出网下载

5

问题五:

省

Cache

之间没协同,造成同一内容各省分别出网获取

问题七:

未共享铁通资源

NDC

×

问题六

:网内

IDC/Cache

已有资源,可能仍走第三方出口

6

7

Cache

系统存在七类协同问题

DPI+

调度器

问题一:

多种疏导方式的定位有待进一步明确

1

骨干网互联互通

Web cache

、

DNS

、流控系统介绍

Web cache

DNS

流控系统

骨干网络架构与路由策略

DNS

DNS

是互联网数据业务的神经系统:

Internet

DNS

系统

①

②

②

域名解析(

DNS

系统实现的功能)的功能是将一个域名(如:

www.chinamobile.com

)解析成一个

IP

地址(告诉网络资源的位置),从而实现路由器之间的路由转发。

域名解析是互联网

业务流程的第一步,运行好坏直接关系数据业务端到端质量

。

DNS

的作用相当于传统话音网的

HLR

。

www.fetionc.om.cn

221.176.31.97

www.sina.com.cn

221.179.180.82

①

DNS

DNS

正常解析流程:

请告诉我

www.163.com

的

IP

地址

缓存里没有

www.163.com

的

IP

地址,去根

服务器查

这个域名由

COM

域管,给你一个

COM

域服务器的

地址

163.com

主区域

服务器知道

www.163.com

的

IP

地址,给你

163.com

主区域服务器

的地址

www.163.com

的地址我这儿有,给你

163

服务器,

地址

a.a.a.a

163.Com

的地址:

a.a.a.a

163.Com

的地址:

a.a.a.a

1

2

3

4

5

6

7

8

获得地址

a.a.a.a

,访问服务器

移动用户

本地

DNS

根服务器

COM

域主服务器

163.com

域主服务器

9

DNS

中国移动

DNS

设置情况:

CMNET

北京

DNS

山东

DNS

天津

DNS

吉林

DNS

四川

DNS

上海

DNS

CMNET-DNS

北京节点

CMNET-DNS

广州节点

……

吉林省用户

全球根

DNS

31

省部署省网

DNS

,骨干网

DNS

设置北京、广州两节点。

骨干

DNS

负责

chinamobile.com/monternet.com

等自有域名解析,省网负责各自子域解析,例如

bj.chinamobile.com

等。

路由原则:骨干网用户

/

系统使用骨干网

DNS

,省网用户

/

系统使用本省系统。

骨干网

/

省网

DNS

为平等

/

扁平化而非上下级关系,省网直接访问全球根

DNS

。

骨干用户

DNS

引入资源访问时的标准

DNS

流程:

用户根据移动骨干

/

省

DNS

反馈的结果,选择第一个解析地址进行访问。将会随机的被引导至电信

/

联通

/

移动网内的资源。

移动节点

域名

=www.qq.com

IP

地址

=1.1.1.1

用户终端

移动骨干

/

省

DNS

网站归属

DNS

服务器

1

、发起解析请求

www.qq.com

3

、

随机顺序返回

2.2.2.2

1.1.1.1

3.3.3.3

2

、转发解析请求

www.qq.com

联通节点

域名

=www.qq.com

IP

地址

=2.2.2.2

电信节点

域名

=www.qq.com

IP

地址

=3.3.3.3

4

、

返回

2.2.2.2

1.1.1.1

3.3.3.3

5

、挑选第一个解析结果进行访问

DNS

引入资源访问时的

DNS

流程

-

智能网站

DNS

:

移动节点

域名

=www.qq.com

IP

地址

=1.1.1.1

用户终端

移动骨干

/

省

DNS

网站归属

DNS

服务器

1

、发起解析请求

www.qq.com

2

、转发解析请求

www.qq.com

3

、

ICP DNS

是智能

DNS

,发现用户来自移动,则反馈移动网内资源

1.1.1.1

;

联通节点

域名

=www.qq.com

IP

地址

=2.2.2.2

电信节点

域名

=www.qq.com

IP

地址

=3.3.3.3

4

、反馈移动网内资源地址

1.1.1.1

;

智能网站

DNS

能够根据用户来源,相应的给出不同运营商网内的服务器地址。

5

、访问移动网内资源

DNS

引入资源访问时的

DNS

流程

-

智能运营商

DNS

:

移动节点

域名

=www.qq.com

IP

地址

=1.1.1.1

用户终端

移动骨干

/

省

DNS

网站归属

DNS

服务器

1

、发起解析请求

www.qq.com

3

、

随机顺序返回

2.2.2.2

1.1.1.1

3.3.3.3

2

、转发解析请求

www.qq.com

4

、运营商

DNS

智能化后,反馈移动网内资源

1.1.1.1

;

联通节点

域名

=www.qq.com

IP

地址

=2.2.2.2

电信节点

域名

=www.qq.com

IP

地址

=3.3.3.3

智能

DNS

可以实施智能

DNS

改造,将网站返回的多

IP

地址进行优选排序,优先将移动网内

IP

反馈给用户

。

如果网站归属

DNS

只反馈给骨干

/

省网

DNS

单一电信

/

联通资源地址,则该方法无效(控制权主要在

ICP

)。

5

、反馈移动网内资源地址

1.1.1.1

;

6

、访问移动网内资源

我省

DNS

现状(改造前)

我省

DNS

现状(改造后)

Web cache

、

DNS

、流控系统介绍

Web cache

DNS

流控系统

骨干网络架构与路由策略

流控系统介绍

DPI

是什么:

-

74

-

DPI

-

D

eep

P

acket

I

nspection

深度包检测:

深

度包检测技术是一种基于应用层的流量检测和控制技术,当

IP

数据包、

TCP

或

UDP

数据流通过基于

DPI

技术的带宽管理系统时,该系统通过深入读取

IP

包载荷的内容来对

OSI

七层协议中的应用层信息进行重组,通过深度分析报文净荷中的特征指纹

Signature

进行业务识别,是协议和应用识别最重要的技术手段。

流控系统介绍

DPI

的作用和应用:

DPI

的作用:

区分流向,分省、分运营商对流量进行分析识别

区分链路中的不同业务流量

区分

IP

、用户的优先保障等级

DPI

的应用

国内外很多运营商已大规模应用

DPI

技术,实现差异化服务和智能管道

互联网出口流控

IDC

流量流向分析

P2P cache

和

web cache

上网日志留存系统

流量清洗系统

域名管控

流控系统介绍

基于

DPI

进行分析控制的典型流程

:

采集

检测

控制

对链路进行物理分光,并输入

DPI

分析

系统

对链路中的包进行深度分析检测,获取所

需的关键业务报文,将这些报文输入至控

制系统

对关键业务

报文进行

分析、丢弃、劫持等

操作,达到对链路中的业务进行分析控制

的作用

流控系统介绍

DPI

部署方式:

1

、串接方式

2

、旁路方式

串接方式:无需分光,集采集、检测、控制能力于一体。控制

有效而

精确,故障时切换至直通模式。

并

接

方式:实现

简单,部署风险小

,需部署分光器,

DPI

设备提供检测能力,控制效果较差,侧重分析能力。

控制系统采用串接方式较多,如流控系统。分析系统采用并接方式较多,如用户上网行为分析系统。

DPI

设备

DPI

设备

端到端流量分析及

控制系统

6

、第三方出口流控

4

、

IDC

流量监测

PCRF

骨干网

DPI

1

、

Gn

数据业务监测

5

、省网流控

IDC

出口

省网出口

SGSN

GGSN

Internet

及业务平台

省网

骨干网出口

AC

WLAN

出口

3

、

WLAN

流控

2

、

PCC

7

、骨干网出口流控

第三方出口

系统

Gn

数据业务监测

PCC

WLAN

流控

IDC

流量管控

CMnet

省

网流控

CMnet

第三

方出口流控

CMnet

骨干

网出口流控

定位

2/3G

数据业务流量流向分析

2/3G

无线网络优化与管控

WLAN

网络流量流向

分析与控制

IDC

资源流量流向

分析

互联网省内流量流向分析及流控

互联网第三方出口流量流向分析及流控

互联网网间及国际出口流量流向分析及流控

能力

2/3G

数据业务排障

2/3G

网络流量分析

为

PCC

管控提供依据

缓解

2G

网络压力的手段之一

2/3G

网络数据业务在无线和核心网侧的精细化管控

WLAN

流量特征分析。

WLAN

分流分析。

WLAN

认证质量和所承载的业务质量分析

IDC

流量流向分析与管控

为互联网网间

/

省间结算提供基础数据

省内数据业务流量流向分析

低价值业务流控

互联网至第三方出口流量流向分析及管控

网间流量流向分析及管控

国际流量流向分析及管控

配合安全管理要求进行特定数据流管控

流控系统现状及问题

系统

现网部署情况

问题

Gn

信令监测系统

15

省已完成合同签署,拟于

2012

年

5

月完成省设备安装及系统上线运行。(广东,福建,辽宁,上海,山东,四川,湖北,江苏,浙江,安徽,北京,陕西,天津,河南,河北)

2012

年仅能完成

15

省部署,其余

16

省尚未规划部署

PCC

初期部署规模为:

31

省

148

个地市,无线网

5.1%

载频,核心网

51%GGSN

。预计

6

月份可完成初期部署

1

、增强

PCC

功能尚有

35.3

万载频缺口,标准

PCC

功能尚有

211

台

GGSN

缺口

2

、

Gx

接口尚未异厂家及全互通,影响用户感知

WLAN

信令监测系统

安徽、内蒙、江苏三省试点

尚未完成试点,现网还不具备能力

IDC

流控系统

北京、上海、广东、浙江、江苏、重庆、四川、山西、江西、安徽、海南、湖南

12

省已经完成部署

尚有

12

省

未建设

IDC

流控系统

省网流控系统

安徽、海南、湖南、浙江、北京、重庆、福建、甘肃、广东、江苏、江西、吉林、辽宁、内蒙、山西、陕西、贵州、上海

18

省已经部署

尚有

13

省未部署省网流控系统

第三方流控系统

25

省均已部署

全网均已部署

骨干网流控系统

骨干网所有至国内运营商出口及国际出口均已部署

问题:各省流控系统部署进度不一,缺乏统一的建设指导原则。

现网多

DPI

部署存在的问题及部署原则:

DPI

建议部署原则:

采集统一:相同

位置的

DPI

,优先考虑复用分光

器。

DPI

统一:争取做到同一套

DPI

能够复用,为不同分析控制系统提供不同数据流。要求对

DPI

能力形成统一规范

标准

硬件

处理能力强、镜像端口个数多。要求软件策略库丰富、数据输出格式

多。

骨干网出口建设

web cache

系统时已复用流控系统的

DPI

模块。

统筹部署:分析

整理全网

DPI

需求,统筹安排,形成关键

DPI

部署点。

SGSN

GGSN

Gn

信令监测系统

公安相关系统

上网日志留存系统

典型问题一:同一链路重复分光后连接不同系统

DPI

缺点:

链路质量及可靠性下降:

多分光器串入链路造成光路

衰减

、链路质量下降;光放(有源)串

入链路

,提高

中断

风险

链路扩容和割接时,需协调考虑多个系统,维护难度增大

光放重复建设。

不同

DPI

对业务特征理解不一致导致无法统一调控全网。

数据业务分析

系统(省内)

信令检测及投诉处理

系统(省内)

数据业务分析和信令检测系统

(集团建设中)

SGSN

GGSN

Gn

典型问题二:同一链路分光连接不同系统的

DPI

缺点:

重复建设

DPI

增加投资

。

DPI

部署要求

PCRF

骨干网

DPI

IDC

出口

省网出口

SGSN

GGSN

Internet

及业务平台

省

网

骨干网出口

WLAN

出口

第三方出口

1

2

3

4

5

城域网

地市出口

7

8

9

10

11

13

某省共部署了

13

套流量相关系统,具体如下

6

12

编号

系统

组网情况

1

Gb

数据业务监测

2

Gn

数据业务监测

在

Gn

接口上部署

1*4

分光器,

Gn

数据业务监测及上网日志留存系统分别部署了

DPI

3

上网日志留存

4

PCC

5

Gi

接口流控

在

Gi

接口上部署

1

*

4

分光器,

Gi

接口流量及不良信息监测系统分别部署了

DPI

功能

6

不良信息监测

7

城域网流控

8

Cmnet

省网出口流控

9

Cmnet

第三方出口流控

10

Cmnet

骨干网出口流控

Cmnet

骨干网出口链路上部署

1*N

分光器,骨干网出口流控及恶意代码检测系统分别部署了

DPI

;骨干网出口流控与流量清洗系统共享

DPI

11

恶意代码检测

12

异常流量清洗

13

IDC

出口流控

总部:明确

组网及能力共享要求

同

一个接口只能够进行一次分光,主路功率应在

80%

以上

同一个接口多个系统并存情况下,

应尽量实现

系统间

DPI

能力共享

研究院:制定

DPI

设备

规范

省

公司:根据

组网要求

进行系统整合

建议

目录

骨干网络架构与路由策略

Web cache

、

DNS

、流控系统介绍

省网组织结构与路由交换方式

高价值业务的区分、标识原则及保障方法

省网组织结构与路由交换方式

一、网络定位

CMNET

省网采用核心、接入两个层次,

CMNet

城域网分为核心层和业务接入控制层两个层次;业务发展初期,

CMNET

省网接入层兼做本地市

CMNET

城域网的核心层,

CMNet

省网与

CMNet

城域网共自治域。

CMNET

省网与骨干网采用不同的自治域进行网络组织。如下图:

省网组织结构与路由交换方式

二、网络规划原则

在网络层次上,

CMNet

省网分为核心层、接入层两个层次。

核心层主要由核心路由器组成,现阶段核心路由器兼做省网出口路由器,主要作用是汇接出省业务量,转发省网内各接入节点之间业务量,并提供

CMNet

省网到

CMNet

骨干网的出口。

接入层主要由接入路由器组成,实现城域内的业务汇聚,提供城市的高速

IP

数据出口。

省网组织结构与路由交换方式

三、网络节点设置原则

CMNET

省网节点地址的选择应考虑传输、机房、电源等各种条件,同时也应考虑省内的维护、支持力量来综合考虑,应保证故障发生时快速响应、及时排障处理。

省网核心节点的设置

:省网核心节点应采取大容量、少节点的方式进行建设,原则上省网内设置2个核心节点;

省网接入节点的设置

:省网接入节点应设置在业务相对比较大且集中的地市级城市的通信枢纽楼,为保障节点的可靠性,一般异局址成对设置接入路由器;

省网组织结构与路由交换方式

五、

网络拓扑结构设计原则

CMNET

省网网络拓扑结构设计时应统筹考虑节点

地域分布

、

光缆传输路由

、被承载业务的

业务量

情况、

业务相关性

等因素;

CMNET

省网核心层宜以

口字型

结构接入本省的

CMNET

骨干网节点;

CMNET

省网

接入

层以

双星型

结构接入省网

核心

层,成对的接入路由器之间直连并构成

口字型

组网;

原则上,不同地市节点路由器之间暂不设置直连链路;

省网组织结构与路由交换方式

六、

路由组织

原则

CMnet

省网

Cmnet

骨干网

AS:

CMNET

省网与骨干网采用不同的自治域进行网络组织;

目前

CMnet

省网采用公有或私有

AS

号

。

IGP:

省网内采用

IGP

路由协议(

ISIS

或

OSPF

),并设置与城域网独立的

IGP

区域(

level

或者

area

),

区域间

:

CMNET

骨干网与国际、国内互联网以及与中国移动互联网

CMNET

省网之间运行

BGP-4

路由协议。

接入

网

接入

网

接入

网

网内路由

:

省网内部互联网业务的路由(公网路由)可通过

IBGP

或

IGP

承载。

若通过

IBGP

承载,则在省网接入层对互联网业务路由进行汇聚;

通过

IBGP

宣告给省网

核心

层,最后在省网核心层对省内路由进行汇聚后宣告给

CMnet

骨干网。若通过

IGP

承载,则在

CMnet

省网核心层对业务路由进行汇聚,并通过

EBGP

宣告给

CMnet

骨干网;

省

网核心

路由器

接入

路由器

网间路由

:

省网与骨干网之间采用外部路由协议

EBGP-4

。

CMNET

省网接收互联网全路由表,省网内部通过细化路由访问

CMNET

网内、网外资源。

RR:

省网设置路由反射器

RR

以反射全省业务的路由。一级

RR

可以由省网汇接路由器兼做;

二级

RR

,可以由省网接入路由器兼做。

VPN:

CMNet

省网内汇接路由器、接入路由器均启动

MPLS

和

LDP

,并作为

MPLS VPN

的

P

设备,城域网内业务接入控制设备作为

PE

设备提供

MPLS VPN

接入。

骨干路由器

省网组织结构与路由交换方式

七、城域网网络协议规划

目录

骨干网络架构与路由策略

Web cache

、

DNS

、流控系统介绍

省网组织结构与路由交换方式

高价值业务的区分、标识原则及保障方法

高价值业务的区分、标识原则及保障方法

在中国移动

CMnet

骨干网网中,

QoS

的实施分为两个部分:

边缘

和

骨干

。

在

边缘

主要完成以下功能:

指定业务类型与级别的策略;

指定资源分配与控制的策略;

业务分类与安全策略的实施;

在

边缘

采用的技术包括:

业务分类(

Classification

:

IP Precedence/DSCP, MPLS EXP

);

速率限制(

Rate-limit

:

CAR

);

在

骨干

主要完成以下功能:

提供大容量、高性能和高可靠性;

提供策略的管理与实施;

提供流式排队与拥塞管理;

在

骨干

采用的技术包括:

带宽分配与拥塞避免(

Bandwidth & Congestion Avoid

:

WRED

);

带宽分配与拥塞控制(

Bandwidth & Congestion Control

:

WFQ

);

高价值业务的区分、标识原则及保障方法

总体原则:接入层实现业务标识(着色),网络层实现分级别转发

接入网

A

骨干网

高优先级

中优先级

低优先级

接入网

B

省网

全部节点:分级别按颜色转发

C

A

B

部署

QOS

策略

所有业务

银业务

金业务

铜业务

网络边界:分业务等级按金银铜着色

特殊链路:区分

ABC

口高级别高保障

云计算

HTML

Web

网页

管道资源按价值调度

业务价值区分

金牌业务

银牌业务

铜牌业务

按需管道

尽力而为

实现目标

网内质量保障:

QOS

保障方案

WLAN

GPRS

传输网

移动互联网

集团大客户

个人宽带

CMnet

省网

/

城域网

CMnet

骨干网

接入层

汇聚层

核心

/

出口层

一般骨干层

核心

/

汇聚骨干层

网间互联层

国内、国际运营商

骨干智能管道

省内智能管道

智能流控

质量监测

业务分析

投诉处理

流控系统

智能规则

探针

探针

端到端智能转发机制

省内智能管道

IDC

IDC

业务划分:省公司根据集团要求进行业务等级划分

地址规划:省公司根据业务分级进行统一地址

队列标示:省公司根据集团

QOS

标记

要

求对业务进行

QOS

标记

流量区分:骨干网和省网间部署

A

出口、

B

出口,疏通保障和非保障业务,保障业务通过

A

出口直接流入骨干网的智能管道

网内质量保障:

QOS

业务标识分类规划(

1

)

网内质量保障:

QOS

业务标识分类规划(

2

)

高价值业务的区分、标识原则及保障方法

省网和骨干网间

QoS

保障方案

:

省网内

根据集团“智能管道”计划的指导意见完成部署;

骨干网和省网间

出省网的流量:通过

QOS

优先保证高等级业务;

入省网的流量:高等级业务优选

A

口流入省网,进入省内智能管道;

CMnet

省网

CMnet

骨干网

CMnet

省网

CMnet

骨干网

出口

1

出口

2

A

出口:宣告

A

类业务路由

B

出口:宣告

B

类业务路由

出方向:通过

QOS

保障

入方向:通过区分链路保障

高价值业务的区分、标识原则及保障方法

骨干网和其它运营商间

保障方案

:

出网的流量:通过

QOS

优先保证高等级业务;

入网的流量:高等级业务优选

A

口流入骨干,进入骨干智能管道;

CMnet

骨干

其它运营商

CMnet

骨干

其它运营商

出口

1

出口

2

A

出口:宣告

A

类业务路由

B

出口:宣告

B

类业务路由

出方向:通过

QOS

保障

入方向:通过区分链路保障

高价值业务的区分、标识原则及保障方法

重点企业客户

/VPN

业务

QoS

保障方案

:

客户

网络

城

域网

城

域网

客户

网络

CMNET

省

网

/

骨干网

Access

出口对下行流量限速

上行流量限速

简单流分类,多个等级的调度和丢包。

Access

端口入方向二三层标记映射,

802.1P

、

DSCP

、

EXP

映射

,

流分类

标记

限速

调度与丢包

Access

端口入方向二三层标记映射,

802.1P

、

DSCP

、

EXP

映射

NE40E

SR7750

NE40E

SR7750

M320

M320

简单流分类,多个等级的调度和丢包。

T1600

简单流分类,多个等级的调度和丢包。

重点企业客户优先级标识为

CS1,CS2

需省网

配合工作

地址规划

根据总部统一的业务分类原则,每类业务的路由掩码不大于

24

位;若掩码大于

24

位,则仅能提供网内服务保障、无法提供网间服务保障。

服务标识

根据总部统一的服务分类原则,省网将发给骨干网数据根据业务分类进行着色,骨干网信任并接受省网侧的服务标识,直接进入骨干网的服务保障通道。

路由标识

根据总部统一的路由标识原则,省网将发给骨干网的路由打上标识,骨干网信任并接受省网的路由标识,骨干网根据标识进行流量监控和服务保障。

省网改造

(

1

)改造要求:省内根据总部统一规划,完成省网的优化改造;总部仅对上送骨干的服务标识、路由标识有要求,对省内服务标识、路由标识、带宽预留不做要求。

(

2

)网管要求:省网应具备对不同级别、不同类别业务的统计能力

接入流程

接入申请

省公司提交实施申请(通过

OA

或

EMOS

),总部、省公司协商确定实施时间

接入实施

省公司完成省网侧局数据配置、总部完成骨干侧局数据配置

测试反馈

省公司上报实施后的业务测试报告,集团、省公司根据测试数据对方案进行优化

感谢聆听!